L’appétit (gargantuesque) des applications d’intelligence artificielle

Jusqu'à présent, il y a peu d'information concernant la quantité d'énergie utilisée par les agents conversationnels alimentés par l’intelligence artificielle (IA), notamment sur la proportion provenant de sources renouvelables.

De grands modèles de langage alimentent de nombreuses applications d’agent conversationnel utilisant l’intelligence artificielle (IA) tels que ChatGPT. Les modèles emploient d'énormes quantités de données, ce qui leur permet de répondre à des messages et des questions en prédisant le mot suivant dans une séquence.

Selon la personne à qui vous demandez, ces nouvelles applications issues de l'IA pourraient résoudre presque tous les problèmes sociaux ou technologiques, supprimer des millions d'emplois ou conduire à l'extinction de l'humanité.

Mais ces modèles nécessitent beaucoup d'énergie pour être mis en place et utilisés.

« Étant donné que les modèles d'IA vont être de plus en plus déployés dans le monde réel, il est plus important que jamais de donner un sens à la manière dont ils affectent le changement climatique et l'environnement », a déclaré Nestor Maslej, directeur de recherche pour l’Institut pour l’intelligence artificielle centrée sur l’humain de l'Université de Stanford, à The Weather Network, la société sœur de MétéoMédia.

Un premier pas coûteux en énergie

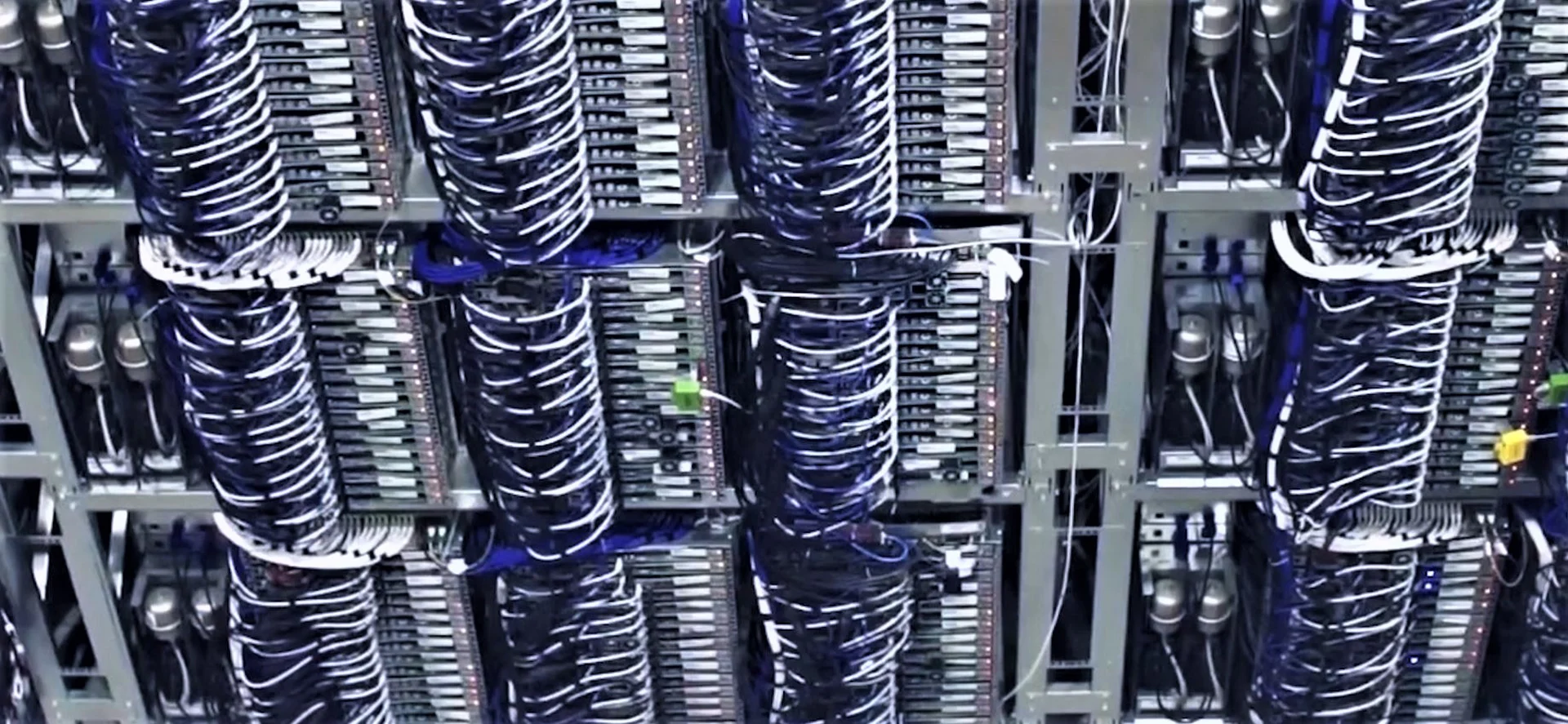

La formation des modèles constitue la première étape. Mais, celle-ci est aussi la plus énergivore, nécessitant l'utilisation de processeurs graphiques (GPU) pour effectuer des calculs.

Mais que veut-on dire par formation des modèles ? Fondamentalement, les scientifiques fournissent un modèle d'IA avec un énorme ensemble de données à étudier.

« Il faut des millions d'heures pour apprendre et discerner des modèles à partir des données », explique Sasha Luccioni, chercheuse scientifique et responsable du climat chez HuggingFace. « Les GPU utilisent essentiellement de l'énergie pour fonctionner et vous avez également tous les frais généraux des centres de données, par exemple, le chauffage, la climatisation, la mise en réseau, le transfert et le stockage des données. »

Comparaison des émissions de carbone entre BLOOM et des LLM similaires. Les nombres en italique ont été déduits sur la base des données fournies dans les articles décrivant les modèles. (Étude d'estimation de l'empreinte carbone de BLOOM)

Mme Luccioni et d'autres scientifiques de HuggingFace ont tenté d'estimer la consommation d'énergie de certains de ces grands modèles de langage dans une étude de 2022 non évaluée par des pairs. Selon leur recherche, le GPT-3 d'OpenAI a émis plus de 500 tonnes métriques de dioxyde de carbone pendant sa phase de formation, ce qui équivaut à parcourir un million de kilomètres dans une voiture à essence. Ce calcul ne tient même pas compte des déchets électroniques ou de l'énergie nécessaire à la fabrication des GPU.

Mais, pour les modèles actuels derrière les modèles d'IA populaires tels que ChatGPT ou Google Bard, il est presque impossible de calculer la consommation d'énergie. La taille des modèles ou le nombre de paramètres et de variables à intégrer ne sont même pas clairs. « À moins que les entreprises ne fournissent des informations, ce ne sont que des conjectures », a indiqué Mme Luccioni.

The Weather Network a communiqué avec les entreprises Microsoft, Google et OpenAI pour obtenir des commentaires. Microsoft a refusé de répondre à la question concernant la quantité d'énergie utilisée pour former GPT-4, qui pourrait remplacer la recherche Bing. Les représentants n'ont pas spécifiquement commenté l'impact de la mise en œuvre de ces modèles d'IA sur l'empreinte carbone de l'entreprise. Un porte-parole de Google a refusé de répondre à des questions similaires. OpenAI n'a pas non plus répondu.

« Dans le cadre de notre engagement à créer un avenir plus durable, Microsoft investit dans la recherche pour mesurer la consommation d'énergie et l'impact carbone de l'IA tout en travaillant sur des moyens de rendre les grands systèmes plus efficaces, à la fois lors de la phase de formation et d’implantation », a déclaré un porte-parole de Microsoft. « Nous continuons également d'investir dans l'achat d'énergie renouvelable et d'autres efforts pour atteindre nos objectifs de durabilité, d'être négatifs en carbone, positifs en eau et zéro déchet d'ici 2030. »

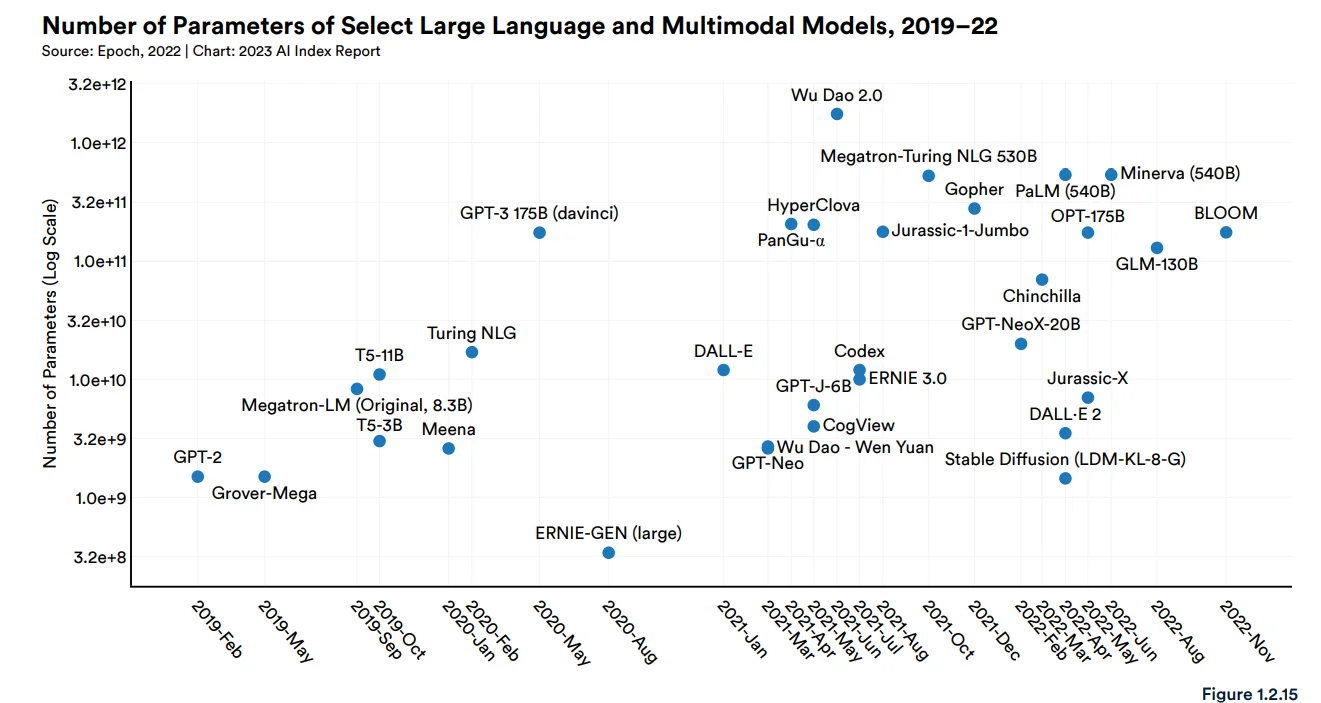

Tableau du rapport sur l'indice d'intelligence artificielle 2023 (lien vers l'étude)

Une demande grandissante

« La consommation d'énergie dépend d'une pléthore de facteurs, y compris la taille des données sur lesquelles les systèmes sont formés ainsi que l'efficacité énergétique des centres de données dans lesquels ces systèmes sont formés », a déclaré M. Maslej. « Si la tendance observée de déploiement de modèles d'IA de plus en plus importants se poursuit, la quantité d'énergie nécessaire pour les former devrait continuer à augmenter. » Les modèles sont passés de 100 millions de paramètres en 2018 à 500 milliards en 2023.

La phase de formation n'est pas la fin de l'histoire pour ces modèles d'IA. Il faut plus d'énergie pour télécharger le modèle sur Internet et le garder en ligne pour que les gens puissent y accéder. Cela vous permet, par exemple, de demander à ChatGPT d'effectuer des tâches ou de répondre à des questions. Chaque fois que le modèle reçoit un nouveau message, il a besoin d'une source d'énergie supplémentaire pour y répondre.

De nombreuses entreprises, dont Google et Microsoft, effectuent également des tests pour savoir si ces modèles d'IA peuvent remplacer les moteurs de recherche. Selon les rapports de Wired, un modèle d'IA utiliserait cinq fois plus d'énergie qu'un moteur de recherche traditionnel.

Il y a aussi le problème des serveurs eux-mêmes et du mélange d'énergie utilisé pour les alimenter. Microsoft possède des serveurs situés dans 28 pays différents et présente des engagements individuels pour améliorer la durabilité dans chaque région.

Par exemple à Singapour, 13 % de l'énergie utilisée par les serveurs provient de l'énergie solaire. En Arizona, 47 % de l'énergie provient d'un mélange d'énergie éolienne, solaire et hydraulique. Cependant, ils ne fournissent pas une mesure globale de l'efficacité de l'utilisation de l'énergie sur tous ces serveurs.

OpenAI déclare que ses serveurs sont situés aux États-Unis sans fournir d'information sur la consommation d'énergie. Google possède des centres de données dans 11 pays indiquant qu'en 2021, 66 % de l'énergie des serveurs de données provenait de sources non émettrices de carbone.

On ne sait pas exactement où se trouvent les serveurs stockant ces modèles de langage. Donc, même si de nombreuses régions du monde emploient des sources d'énergie renouvelable, il est pour l'instant impossible de déterminer la quantité d'énergie renouvelable utilisée pour alimenter la révolution de l'IA.

Vignette : serveurs au centre de données OVHcloud à Beauharnois, au Québec. (MétéoMédia)

D'après les informations de Simon Spichak, journaliste à The Weather Network